阿里云推出 Qwen2.5-Turbo 专为处理长文本场景设计

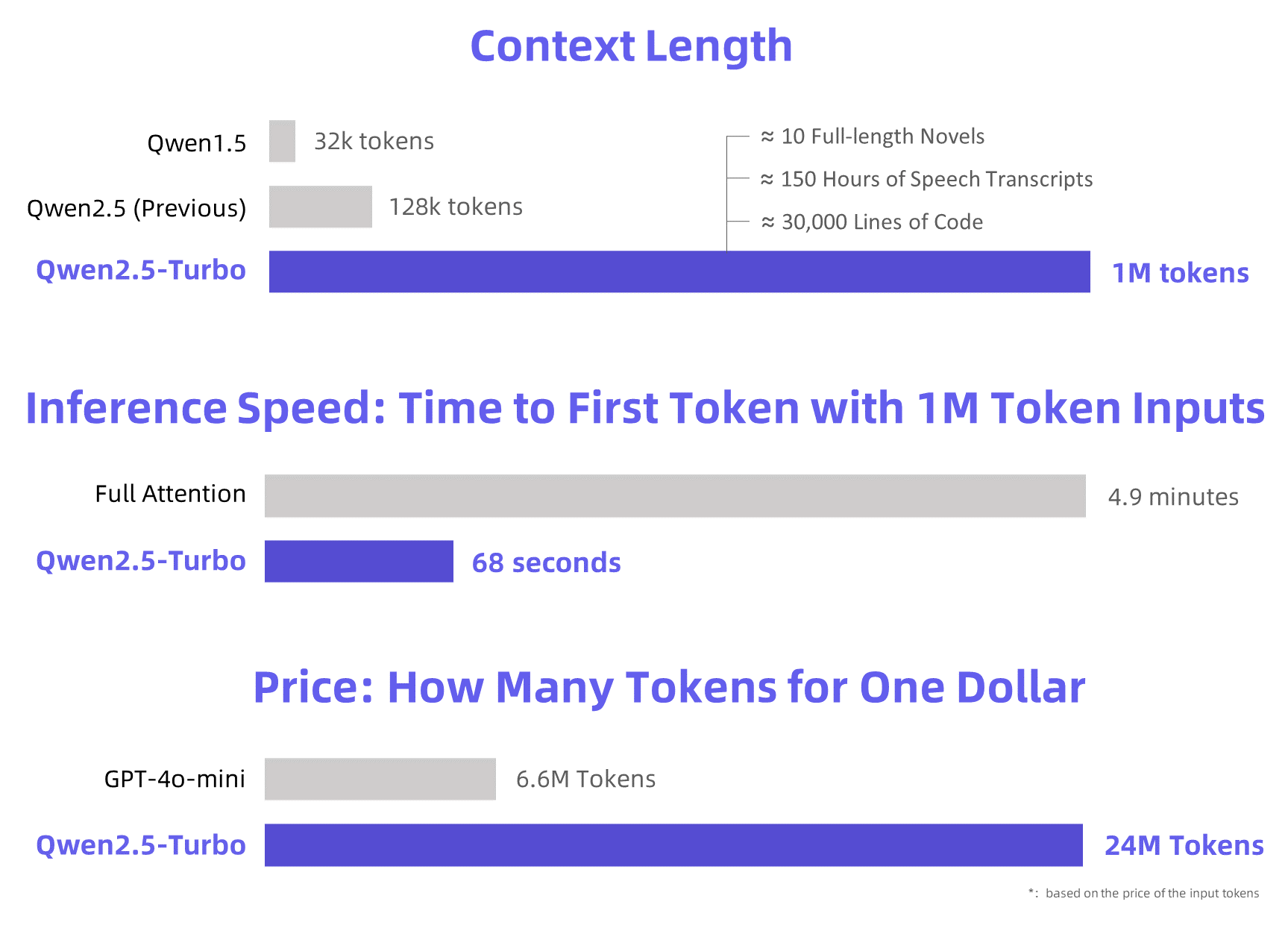

- 支持 100 万 Token 的上下文长度,相当于 10 部完整小说、150 小时的语音转录或 30,000 行代码。

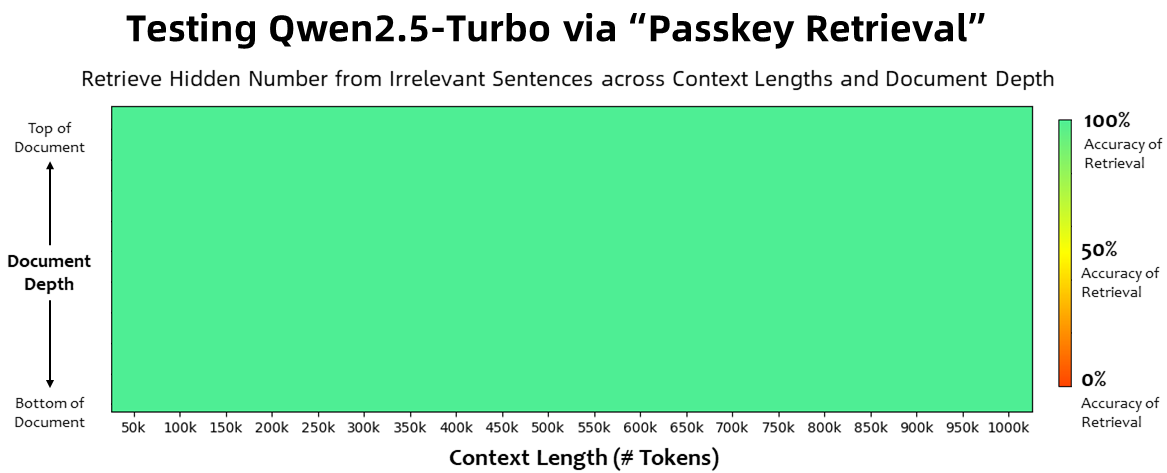

- 在 Passkey Retrieval 任务中实现 100% 的准确率。

- 处理 100 万 Token 的时间从原来的 4.9 分钟减少到 68 秒,提升 4.3 倍。

- 处理 100 万 Token 的费用为 ¥0.3,与 GPT-4o-mini 相比,在相同成本下处理 3.6 倍的内容。

官方介绍:https://qwenlm.github.io/blog/qwen2.5-turbo/

在线演示:https://huggingface.co/spaces/Qwen/Qwen2.5-Turbo-1M-Demo

API文档:https://help.aliyun.com/zh/model-studio/getting-started/first-api-call-to-qwen

1. 长文本任务性能

超长文本处理能力

- 上下文长度支持 100 万 Token:

- 能处理超长文本,约等于 10 部完整小说或 30,000 行代码。

- Passkey Retrieval 任务:实现 100% 准确率。

- 长文本评估基准测试表现优异:

- RULER 基准:得分 93.1,高于 GPT-4(91.6)和 GLM4-9B-1M(89.9)。

- LV-Eval 和 LongBench-Chat:在多个长文本任务中超越 GPT-4o-mini,处理超长上下文任务能力强。

细节捕获与复杂理解

细节捕获与复杂理解

- 在超长上下文中,能准确捕捉隐藏信息,回答复杂问题,并找到大量上下文中的关键信息。

2. 短文本任务性能

- 短文本任务稳定性:

- 长上下文支持没有影响短文本任务的能力。

- 在短文本基准测试中表现与 GPT-4o-mini 相当。

- 优秀的长文本理解能力:

- 在复杂的长文本任务(如 LV-Eval、LongBench-Chat)中表现优于 GPT-4o-mini。

- 可处理超过 128K Token 的任务场景。

- Qwen2.5-Turbo 支持的上下文长度是 GPT-4o-mini 的 8 倍,但短文本任务性能几乎无损。

3. 推理速度

- 时间优化:

- 在 100 万 Token 输入下,首次生成 Token 的时间缩短至 68 秒,提升 4.3 倍(原为 4.9 分钟)。

- 稀疏注意力机制:显著压缩计算量,效率提升 12.5 倍。

- 硬件兼容性:

- 在多种硬件配置下都能提供稳定的推理速度。

4. 性价比

- 高效计算:

- 相同成本下,Qwen2.5-Turbo 处理的 Token 数是 GPT-4o-mini 的 3.6 倍。

- 每处理 100 万 Token 的费用仅为 ¥0.3。

5. 综合评价

- 优于同类竞品:在长文本任务中超越 GPT-4 和其他同类模型。

- 任务适应性强:兼具长文本理解的深度和短文本处理的精准性。

- 推理效率高:无论在超长文本还是复杂任务中,都能以更快的速度完成。

声明:本站资源来自会员发布以及互联网公开收集,不代表本站立场,仅限学习交流使用,请遵循相关法律法规,请在下载后24小时内删除。 如有侵权争议、不妥之处请联系本站删除处理! 请用户仔细辨认内容的真实性,避免上当受骗!